1 概述

1.1 版本

| 服务器版本 |

|---|

| v7.3.0及之后版本 |

1.2 应用场景

当源数据中存在重复数据时,会导致数据库文件变大,增加存储和读写的开销,使得查询数据的效率降低。因此,一般需要对重复数据进行去重处理。

数据去重可以避免数据重复存储,从而提高数据库的存储效率,降低存储成本。在数据清洗过程中,去重还可以避免重复的数据对数据分析和挖掘的影响,确保分析结果的准确。

1.3业务场景

- 客户信息管理:银行或机构通过“姓名+证件号+手机号”组合字段去重,避免重复联系客户。

- 数据迁移:在系统集成多个业务系统数据时,匹配主字段去重,消除系统重复记录。

1.4 功能简介

【数据去重】可将上一个节点数据按照去重字段设置对重复数据记录进行聚合处理。

2 功能说明

【数据去重】设置包括:配置和数据预览。

| 步骤 | 描述 |

|---|---|

| 步骤一:连接上游节点 | 获取需要去重的数据表。 |

| 步骤二:去重字段配置 | 添加存在重复数据的字段,并设置去重规则。 |

| 步骤三:数据预览 | 查看去重后的字段数据。 |

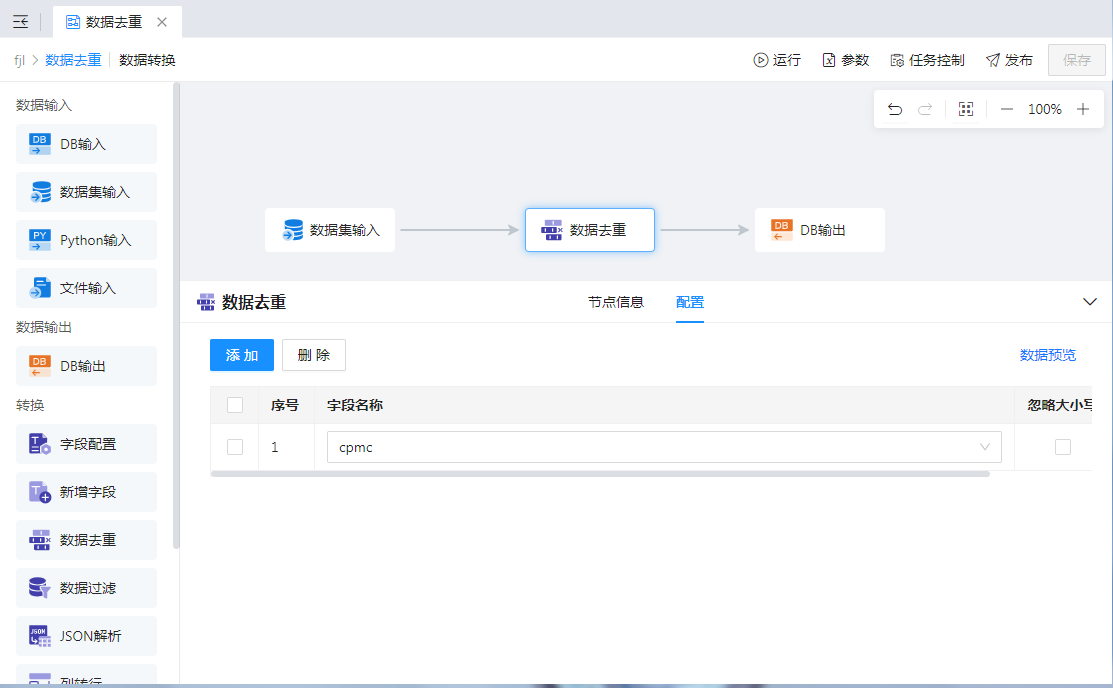

1、去重字段配置

添加存在重复数据的字段,并设置去重规则,即是否“忽略大小写”。如下图:

支持配置多个去重字段,多个去重字段是and的关系,即所有去重字段内容均相同时才视为重复数据。

2、数据预览

点击“数据预览”将根据设置的去重条件对数据进行去重处理,显示去重后的结果。如下图:

注:

1)去重后保留的是第一条数据;

2)当去重字段为空时,该字段内容为空和Null均视为字段数据为空。

作者:fancy 创建时间:2024-10-14 10:48

最后编辑:倪 更新时间:2025-09-30 17:19

最后编辑:倪 更新时间:2025-09-30 17:19

扫码关注网盛数新公众号,获取更多帮助资料

扫码关注网盛数新公众号,获取更多帮助资料